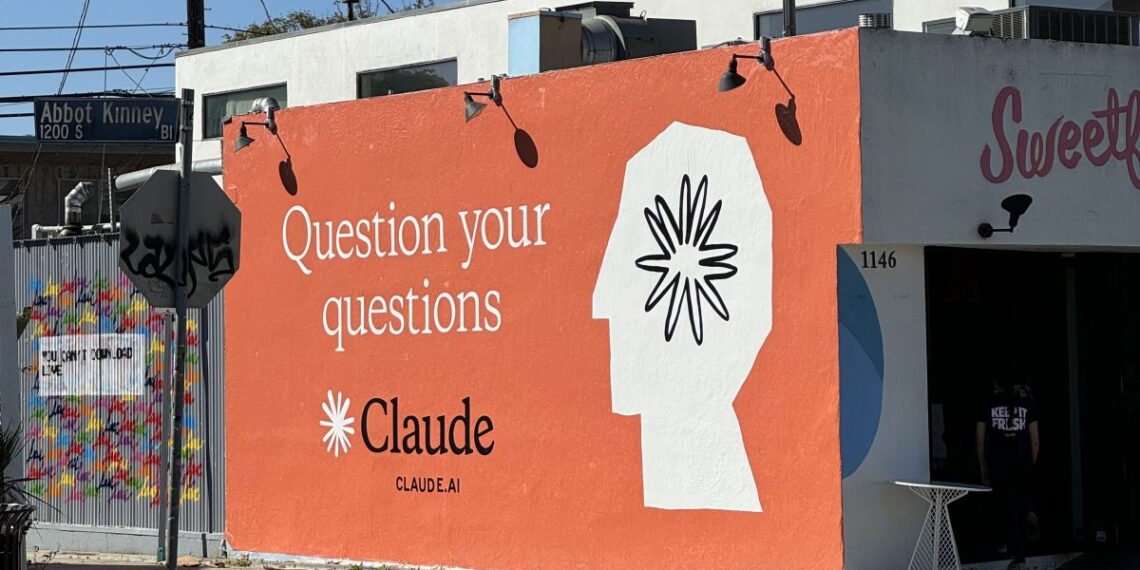

El ámbito de la inteligencia artificial está experimentando una transformación significativa, especialmente en lo que respecta a las políticas de manejo de datos de usuario. Desde la fecha de publicación original, el 28 de agosto de 2025, Anthropic, una empresa en el campo de la IA, ha implementado cambios sustanciales en la manera en que gestiona la información de sus usuarios, particularmente para los usuarios de su asistente Claude. Hasta el 28 de septiembre de 2025, todos los usuarios deben decidir si desean que sus conversaciones sean utilizadas para entrenar modelos de IA.

Históricamente, Anthropic no utilizaba los datos de chat de consumidores para el entrenamiento de modelos, pues la información se eliminaba de sus servidores en un plazo de 30 días, salvo en situaciones en las que se requería su preservación por razones legales o de política interna. Sin embargo, la compañía ha decidido ampliar su periodo de retención de datos a cinco años para aquellos que no se opten por salir de este proceso.

Este cambio no afecta a los clientes empresariales, que incluyen a aquellos que usan Claude Gov, Claude para el Trabajo, o Claude para la Educación, quienes están exentos de estas políticas de uso de datos, de manera similar a cómo OpenAI protege a sus clientes empresariales.

Según la empresa, el propósito de esta modificación es incentivar una mayor participación de los usuarios en el desarrollo de la seguridad de los modelos, argumentando que al no optar por no participar, los usuarios contribuirán a mejorar la capacidad de sus sistemas para detectar contenido dañino y mejorar en habilidades como análisis y razonamiento. Sin embargo, se puede visualizar también un contexto más amplio: la competencia feroz en el desarrollo de IA exige a las empresas acceder a grandes volúmenes de datos de calidad, y tener acceso a millones de interacciones con Claude podría mejorar la posición competitiva de Anthropic frente a gigantes como OpenAI y Google.

Además de la presión competitiva, estas nuevas políticas parecen reflejar una tendencia más amplia en la industria de la IA, donde tanto Anthropic como OpenAI están bajo un escrutinio creciente por sus prácticas de retención de datos. En un incidente reciente, OpenAI está enfrentando una orden judicial que exige la retención indefinida de todas las conversaciones de ChatGPT, un desarrollo que ha suscitado preocupaciones sobre el cumplimiento de las promesas de privacidad hacia sus usuarios.

La situación se complica aún más por el desinterés que muchos usuarios muestran hacia los cambios en las políticas de uso. A menudo, estos cambios son anunciados de manera relegada en los comunicados de prensa, lo que puede dar la impresión de que son de menor importancia de lo que realmente son.

La implementación de estas nuevas políticas también ha puesto de relieve el dilema de la complejidad en torno a la obtención del consentimiento del usuario. Por ejemplo, mientras que los nuevos usuarios deben elegir su preferencia durante el registro, los usuarios existentes se enfrentan a un procedimiento que podría no garantizar la plena comprensión de los acuerdos nuevos, dada la manera en que se estructuran las solicitudes de aceptación.

La administración federal, a través de la Comisión Federal de Comercio, ha manifestado preocupaciones sobre la claridad y transparencia requeridas en las políticas de privacidad y uso de datos, especialmente en un entorno donde el consentimiento significativo se parece cada vez más inalcanzable.

Dadas las implicaciones de estas |cambios, el futuro del manejo de datos en la inteligencia artificial parece estar en una encrucijada, donde la innovación y el respeto a la privacidad del usuario deben encontrar un equilibrio que satisfaga ambas necesidades.

Gracias por leer Columna Digital, puedes seguirnos en Facebook, Twitter, Instagram o visitar nuestra página oficial. No olvides comentar sobre este articulo directamente en la parte inferior de esta página, tu comentario es muy importante para nuestra área de redacción y nuestros lectores.